正文开始

如果你对自动化操作感兴趣,或者想通过编写脚本软件提升工作效率,这篇文章会为你提供清晰的思路和实用的方法,自制脚本软件并不需要高深的编程能力,只要掌握基础逻辑并选择合适的工具,就能一步步实现目标,以下是详细的实践指南。

**一、明确脚本软件的核心需求

在动手开发之前,先问自己几个问题:

1、脚本需要解决什么问题?

批量处理文件、自动填写表单、监控网页更新等。

2、目标用户是谁?

如果是自用,可以简化功能;如果面向他人,需考虑易用性和兼容性。

3、运行环境是什么?

脚本需要在Windows、MacOS还是Linux系统上运行?是否需要依赖浏览器或其他软件?

关键点:需求越具体,开发方向越明确,避免“大而全”的设计,优先解决核心痛点。

**二、选择合适的开发工具

根据脚本的复杂度和运行环境,选择适合的工具或编程语言:

**1. 轻量级脚本工具

AutoHotkey(Windows)

适合模拟键盘鼠标操作、自动化重复任务,语法简单,社区资源丰富。

Python + 第三方库

例如selenium(网页自动化)、pyautogui(控制键盘鼠标),Python语法简洁,适合处理复杂逻辑。

**2. 浏览器自动化工具

JavaScript + Tampermonkey插件

可直接在浏览器中运行脚本,修改网页内容或拦截请求。

Puppeteer(Node.js)

适合需要深度控制Chrome浏览器的场景,例如爬虫或自动化测试。

**3. 跨平台工具

Bash脚本(Linux/MacOS)

适用于文件管理、服务器运维等场景。

PowerShell(Windows)

功能强大,支持系统级操作。

建议:优先选择学习成本低、社区支持好的工具,例如Python的通用性较强,适合长期发展。

**三、脚本开发的步骤与技巧

**1. 拆分任务模块

将复杂任务拆解为多个小功能,逐个实现,一个自动下载图片的脚本可以分为:

- 抓取网页链接

- 解析图片地址

- 下载并保存到本地

优势:模块化开发便于调试和后期维护。

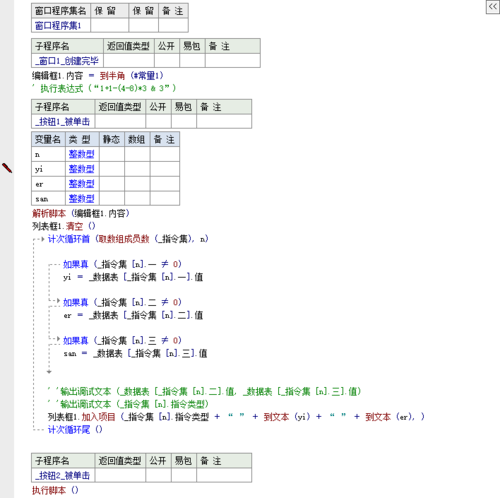

**2. 编写代码的逻辑框架

以Python为例,一个自动化脚本的基本结构如下:

导入依赖库

import requests

from bs4 import BeautifulSoup

定义核心函数

def download_images(url):

# 抓取网页内容

response = requests.get(url)

# 解析图片链接

soup = BeautifulSoup(response.text, 'html.parser')

images = soup.find_all('img')

# 下载并保存

for img in images:

img_url = img.get('src')

# 添加异常处理

try:

img_data = requests.get(img_url).content

with open('image.jpg', 'wb') as f:

f.write(img_data)

except:

print("下载失败:", img_url)

调用函数

if __name__ == "__main__":

download_images("https://example.com")技巧:

- 添加注释,方便后期回顾或他人阅读。

- 使用try...except捕获异常,避免脚本中途崩溃。

**3. 测试与调试

单元测试:逐个验证模块功能是否正常。

日志记录:输出关键步骤的结果,帮助定位问题。

用户反馈:如果脚本提供给他人使用,收集反馈并优化体验。

**四、提升脚本的可靠性与效率

**1. 优化代码结构

- 避免重复代码,封装常用操作为函数。

- 使用配置文件管理参数(如路径、账号信息),提高灵活性。

**2. 兼容性处理

- 考虑不同操作系统的路径格式(例如Windows用,Linux用/)。

- 处理网络波动或目标网站改版导致的异常。

**3. 安全性注意事项

- 避免在代码中明文存储敏感信息(如密码、API密钥)。

- 如需联网,添加请求频率限制,防止被封禁IP。

**五、持续学习与迭代

脚本开发是一个动态优化的过程,你可以通过以下方式提升技能:

1、阅读开源项目:GitHub上有大量脚本案例,学习他人的代码风格和设计思路。

2、参与技术社区:例如Stack Overflow、Reddit的编程板块,解决实际问题。

3、定期重构代码:随着需求变化,删减冗余功能,提升运行效率。

个人观点

自制脚本软件的本质是将重复劳动转化为自动化流程,这个过程不仅需要技术能力,更需要解决问题的思维方式,即使你编写的第一个脚本只能节省5分钟时间,长期积累下来,效率的提升会远超预期,不必追求一步到位,从简单需求入手,逐步迭代,你会逐渐发现编程的乐趣与价值。

正文结束

评论列表 (2)

如何自制脚本软件?教你轻松掌握脚本编写技巧,实现个性化自动化操作。

2025年06月30日 05:05如何自制脚本软件?详细回答:要制作自己的脚本书,首先需要掌握编程语言如Python、JavaScript等,接着设计功能框架和界面布局;编写代码实现各项功能和交互逻辑后测试优化并发布分享给他人使用即可成功完成软件开发过程的关键步骤了!

2025年10月15日 23:41