电脑如何计算公式?这是一个看似简单却蕴含深意的问题,作为现代生活中不可或缺的工具,电脑的计算能力几乎无处不在,从简单的加减乘除到复杂的科学模拟,都离不开它的核心运作,我想和你聊聊电脑是如何实现这些计算的,希望能用通俗易懂的方式,带你一窥其中的奥秘。

电脑的计算基础建立在二进制系统上,你可能知道,人类习惯用十进制数字,比如0到9,但电脑内部只识别0和1,这是因为电脑的硬件,如晶体管,只有两种状态:开或关,这种二进制逻辑让电脑能够处理所有信息,包括数字、文字甚至图像,当电脑遇到一个公式时,2+3”,它不会直接理解这个符号,而是先将这些数字转换成二进制代码,2在二进制中是“10”,3是“11”,然后电脑通过内部的算术逻辑单元(ALU)来执行加法操作,ALU是CPU的一部分,专门负责数学运算,它会将这两个二进制数相加,得到结果“101”,也就是十进制的5,这个过程虽然听起来简单,但却是电脑计算的核心。

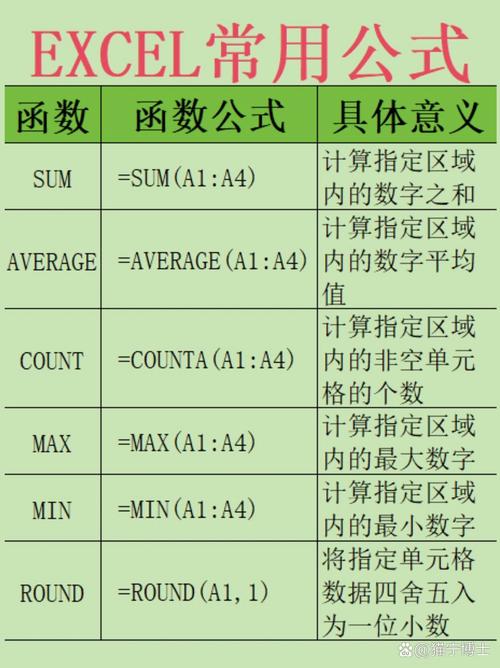

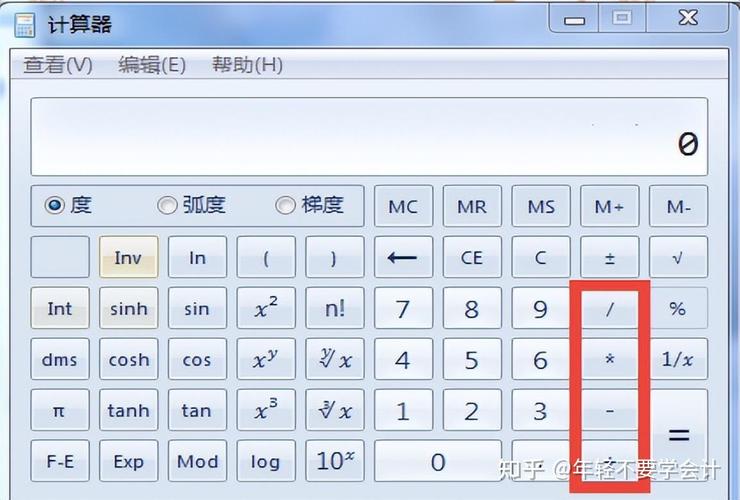

让我们看看硬件是如何配合的,电脑的中央处理器(CPU)就像大脑,负责协调所有计算任务,当你输入一个公式到电脑中,比如通过计算器应用或编程软件,CPU会接收到指令,这些指令被翻译成机器语言,也就是一系列0和1的代码,CPU中的ALU根据这些代码执行具体操作,比如加法、减法或更复杂的函数,内存(RAM)临时存储数据和中间结果,确保计算过程流畅,如果你在Excel中输入一个公式“=A1+B1”,电脑会先读取单元格A1和B1的值,将它们加载到内存中,然后由CPU执行加法,最后将结果返回给显示界面,整个过程在毫秒内完成,得益于硬件的高效协作。

在软件层面,编程语言和操作系统扮演了关键角色,高级编程语言如Python或C++允许我们写出易于理解的公式,x = y + z”,但电脑不能直接执行这些代码,它需要编译器或解释器将其转化为机器代码,编译器会将整个程序翻译成二进制指令,而解释器则逐行执行,当你用Python写一个简单的计算脚本时,解释器会一步步将代码转化为CPU能理解的指令,从而执行公式,操作系统则管理这些进程,确保资源分配合理,避免冲突,这就像是一个翻译官,把人类的意图传达给机器,让计算变得可行。

举一个更具体的例子,假设我们要计算圆的面积,公式是“πr²”,在电脑中,这个公式会被分解成多个步骤:读取半径r的值;计算r的平方;乘以π的近似值(通常存储在内存中);输出结果,电脑通过循环和条件判断来处理复杂公式,确保精度和效率,在科学计算中,电脑可能使用迭代算法来逼近精确值,这体现了它在处理不确定性时的灵活性。

电脑的计算能力不仅限于简单算术,还能处理矩阵运算、微积分甚至人工智能模型,在机器学习中,电脑通过大量数据训练模型,执行复杂的线性代数公式来预测结果,这依赖于并行计算技术,多个CPU核心或图形处理器(GPU)同时工作,加速处理过程,这种进步让电脑在医疗、金融等领域发挥巨大作用,帮助人类解决以前难以想象的难题。

从个人角度来看,电脑的计算方式让我深感科技的魅力,它不仅仅是冷冰冰的机器,而是人类智慧的延伸,每当我使用电脑解决一个复杂问题时,我都能感受到那种从抽象公式到具体结果的转化过程,仿佛在见证一场无声的对话,随着量子计算等新技术的发展,电脑的计算能力可能会更上一层楼,带来更多突破,但无论如何,核心原理依然扎根于二进制和硬件协作,这提醒我们,简单的基础往往支撑着最复杂的创新。

电脑通过二进制系统、硬件组件和软件协作,将公式转化为可执行的计算,这个过程既精密又高效,展现了人类工程学的成就,希望这篇文章能让你对电脑的计算方式有更深的了解,如果你有更多疑问,欢迎继续探索这个有趣的话题。

评论列表 (0)